Monitor de Odio - Hatemedia.

Proyecto PID2020-114584GB-I00, financiado por la Agencia Estatal de Investigación - Ministerio de Ciencia e Innovación.

Metodología empleada para el desarrollo del Monitor de Odio, del proyecto Hatemedia

En el desarrollo del proyecto Hatemedia se han aplicado diferentes técnicas de investigación cuantitativas. Como por ejemplo, la CRISP-DM (Cross-Industry Standard Process for Data Mining). Esto ha permitido el desarrollo interactivo e iterativo de un proceso de minería de datos sobre los textos usados para el diseño progresivo de los diferentes algoritmos que atienden a la clasificación diferenciada de mensajes tendentes al odio, en medios informativos digitales españoles, según intensidad y tipo de odio.

Para el desarrollo del Monitor de Odio, se han tomado los cinco medios informativos digitales, considerados en el proyecto Hatemedia (PID2020-114584GB-I00), financiado por la Agencia Estatal de Investigación – Ministerio de Ciencia e Innovación: 20 Minutos, ABC, El Mundo, La Vanguardia, y El País.

La selección de los medios informativos digitales tomados para el desarrollo de este Monitor de Odio se hizo en vista que:

Solo se toman dentro del proyecto Hatemedia, las noticias y comentarios publicados en español dentro de cada uno de estos medios estudiados. |

El proyecto Hatemedia tiene dos objetivos generales:

- Analizar cómo se difunden las expresiones tendentes al odio en los entornos digitales asociados a los medios informativos profesionales en España

- Favorecer la detección y monitoreo de este tipo de expresiones en los entornos digitales asociados a los medios informativos profesionales en España

Es en el segundo objetivo general que el Monitor de Odio que se presenta intenta avanzar en brindar a los medios informativos digitales en España, pero también a las instituciones públicas y del Tercer Sector, comunidad científica y profesionales interesados en el estudio y desarrollo de acciones destinado a la lucha de expresiones tendentes al odio en los escenarios digitales actuales, una herramienta orientada al seguimiento en tiempo real del fenómeno abordado.

Lo expuesto en el párrafo anterior desde los siguientes principios:

- El sector de la comunicación, sus instituciones y profesionales, necesitan herramientas que le ayuden a un control más proactivo de este fenómeno.

- La comunidad científica, requiere contar con datos fiables que les ayude al seguimiento y comprensión de este fenómeno.

- Las entidades del Tercer Sector, necesitan también contar con herramientas que sirvan al monitoreo de este fenómeno, que les ayude a ser más asertivos en las acciones impulsados por sus miembros.

El Monitor de Odio busca brindar a todos los actores potencialmente interesados en la diseminación de expresiones tendentes al odio, a medir la presencia de estas desde los escenarios digitales usados por los medios informativos digitales españoles.

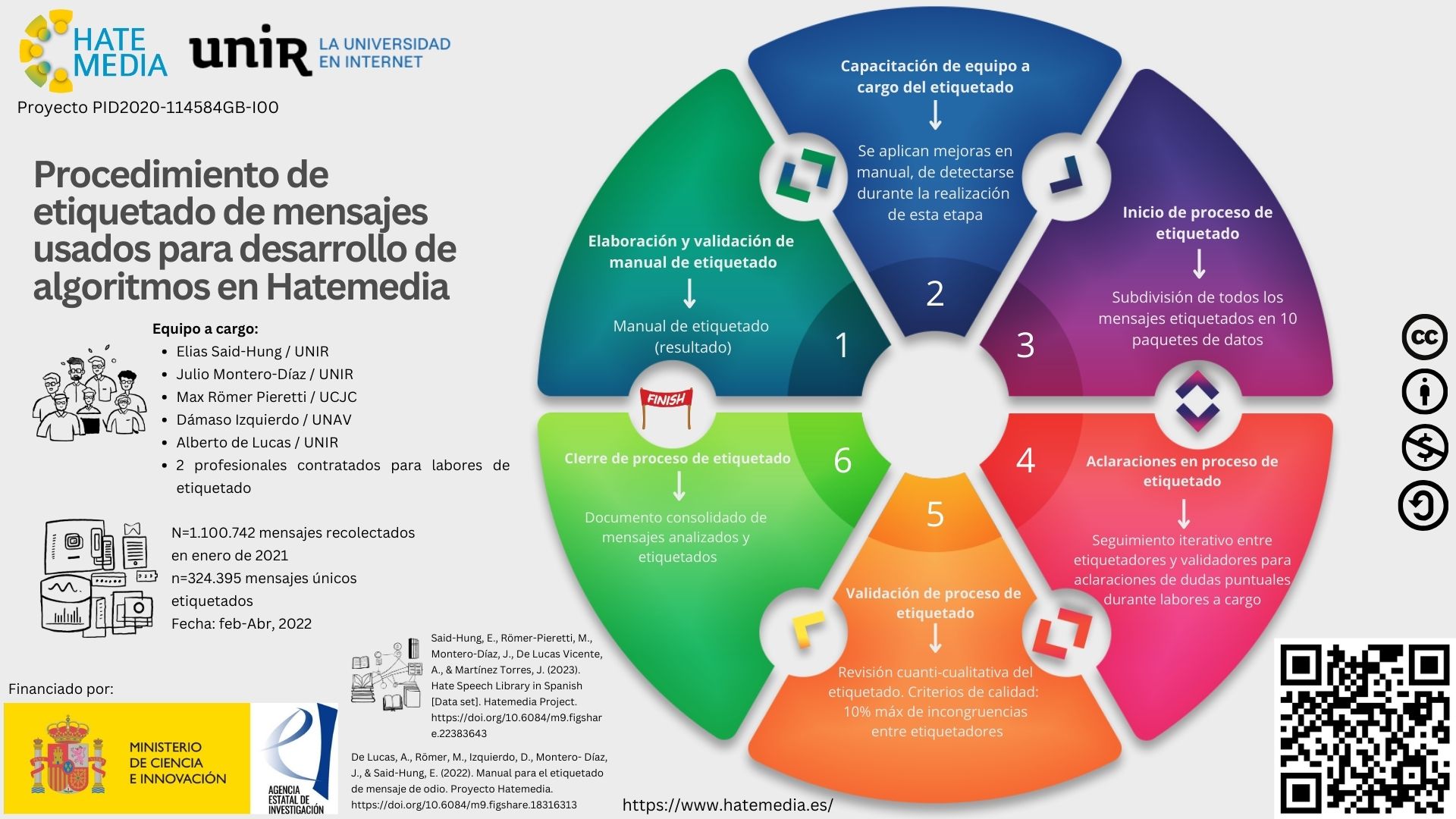

Como paso previo al desarrollo del Monitor de Odio, se recolectó, durante el mes de enero de 2021, un total de 1.100.742 mensajes, asociados a medios informativos digitales en España. De este total de datos asociados únicamente al mes de enero de 2021, se excluyeron 776.356 mensajes por motivos de duplicación o repetición. Por tanto, solo se dio por válido, para el etiquetado de mensajes necesario para el entrenamiento de algoritmos, un total 324.395 mensajes únicos publicados en enero de 2021, tomados de X (antes Twitter) y portales institucionales de los medios informativos digitales. Mensajes que fueron recolectados a través de técnicas automáticas de web scraping (portales web) y el API de Twitter, basado en Python.

Figura 1. Ciclo de trabajo del equipo a cargo del etiquetado de mensajes de odio:

Durante el proceso de construcción del algoritmo de detección de odio se logró alcanzar 4 niveles de intensidad de odio en el proyecto Hatemedia:

Además, se logró clasificar hasta 5 tipos de odio:

|

El trabajo de etiquetado que sirvió de base para el desarrollo de la versión de prueba del Monitor de Odio, se desarrolló de acuerdo con lo expuesto en la figura 1:

Cada una de estas etapas del ciclo de trabajo, siguieron el esquema de ejecución que muestra la figura 2, con el fin de asegurar la validez del proceso de etiquetado realizado para el diseño de los modelos de algoritmos de clasificación de mensajes con términos tendentes al odio en medios informativos digitales en España.

Figura 2. Ciclo de trabajo de procedimiento de etiquetado de mensajes recabados

Este proceso permitió identificar el total de los mensajes etiquetados y distinguir características de estos a partir de las siguientes categorías:

- Presencia o no de expresiones tendentes de odio.

- Tipo de odio detectado dentro del proyecto Hatemedia: General o indefenciado, político, sexual, misógino y xenófobo.

- Nivel de intensidad del odio observado en mensaje (nivel 1 al 4), que finalmente se ha logrado medir en el proyecto Hatemedia.

La validación de cada uno de los 10 paquetes de mensajes empleados para el etiquetado del total de mensajes que conformaron la muestra usada para el desarrollo del modelo de aprendizaje automático de odio, tomó como referente el procedimiento aplicado en otros estudios (Basile et al., 2018), añadiendo otros pasos adoptados por el equipo a cargo de este trabajo:

- Cada paquete de mensajes fue revisado por cada uno de los profesionales de apoyo, formados para dicha tarea.

- Los paquetes revisados por cada profesional, se consolidaba en un único archivo. Así se identificaron los mensajes clasificados de forma diferente por estos. Dichos mensajes eran revisados por ambos profesionales, en un encuentro coordinado para tal fin, con el apoyo de uno de los expertos participante. Este último aclaraba las dudas conceptuales que motivaron las diferencias observadas. Si no llegaban a un acuerdo, se dejaba evidencia de los diferentes criterios aplicados.

- El documento resultado de la evaluación individual y de esta revisión grupal se remitía a los expertos que acompañaban el proceso. Llegado este punto, se hacían dos procesos de validación o control de calidad interna del documento:

- Se cuantificaba el porcentaje de mensajes etiquetados con diferencia entre pares dentro del paquete. Si el porcentaje de mensajes era mayor del 10% del total de los mensajes etiquetados con términos tendentes de odio, se devolvía al equipo de profesionales, para una nueva fase de revisión grupal, y se repetía el procedimiento señalado. Si el porcentaje era igual o menor del 10%, se daba por válido en esta primera fase de control.

- Los paquetes validados en el apartado anterior luego pasaban a uno de los miembros del equipo de expertos a cargo de este trabajo, y se hacía una verificación aleatoria del 10% de la totalidad de mensajes con congruencia de etiquetado. En este proceso el experto asumía el papel de etiquetador, revisando ese porcentaje de mensaje. Solo se daba por válido cada paquete que tuviese 10% o menos de incongruencia del total validado aleatoriamente, a nivel de lo hecho por los profesionales de apoyo y el experto a cargo de esta tarea. Si el porcentaje de incongruencias era mayor al porcentaje indicado, se volvía a pasar el paquete a profesionales para una tercera revisión, con el apoyo de los expertos, quienes aclaraban dudas conceptuales requeridas, y se repetía de nuevo los pasos, cuantitativos y de verificación cualitativa del trabajo pautado.

- Los mensajes validados en cada paquete que presentaron congruencia de clasificación, se separaban de los que habían presentado algún tipo de incongruencia. Estos últimos, como se ha dicho, volvían a re-etiquetarse y una vez realizado el proceso se integraban con el resto ya validado.

El resultado del proceso de etiquetado sirvió de base para la construcción de una Librería de de expresiones tendentes al odio en medios informativos digitales, con 7.210 lemas simples y compuestos más repetidos (Said-Hung et al., 2023). Lemas que fueron usados como referentes para el desarrollo de lo mostrado en el Monitor de Odio desarrollado desde el proyecto Hatemedia, con el financiamiento de la Agencia Estatal de Investigación – Ministerio de Ciencia e Innovación.

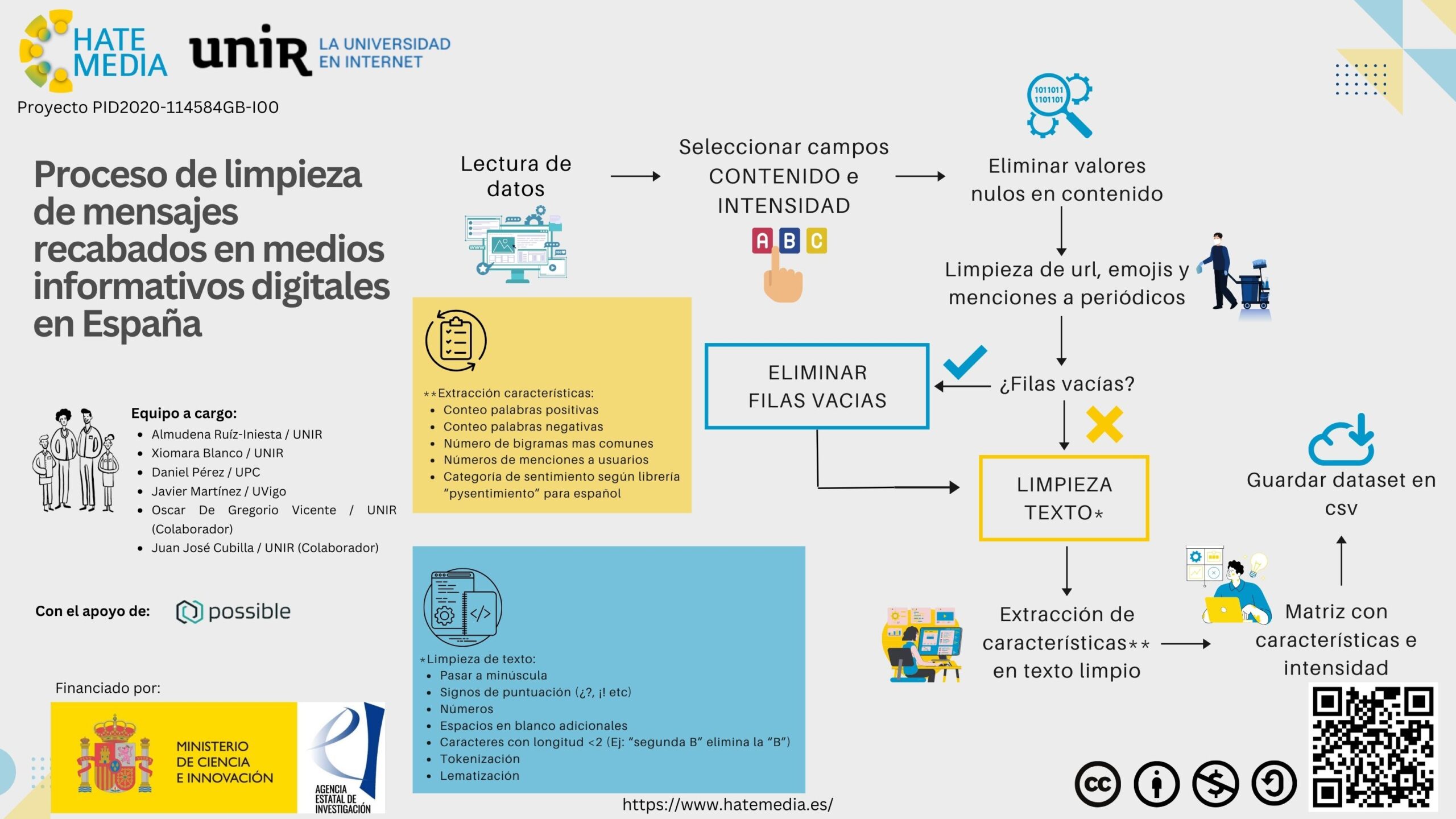

Una vez finalizado el proceso de etiquetado de mensajes con expresiones tendentes al odio, se procedió a emplear tanto los mensajes como los lemas identificados para identiticar el resto de mensajes recabados desde enero 2021 hasta julio de 2022, a partir del cumplimiento de los siguientes pasos:

- Identificación de los datos relevantes.

- Desarrollo de limpieza de datos, destinado a:

- La eliminación de mensajes nulos y/o duplicados, para evitar el sobre-dimencionamiento de la presencia de estas expresiones.

- La eliminación de URLs, emojis y menciones a los propios medios tomados como base de desarrollo de este monitor.

- La eliminación de filas vacías generadas durante el proceso de recolección de los datos.

- La conversión de la totalidad del texto a minúscula

- La eliminación de signos de puntuación

- La eliminación de espacios en blanco adicionales

- La eliminación de palabras con longitud menor a 2 caracteres (eg. ¨el¨, ¨la¨).

- La eliminación de Stopwords.

- La tokenización de los mensajes.

- La lematización de las palabras para una mayor precisión del proceso de detección de mensajes con expresiones tendentes al odio.

El procedimiento antes descrito siguió los pasos indicados por Zhang et al. (2018), mostrados en la figura 3.

Figura 3. Proceso de limpieza de mensajes recabados en medios informativos digitales en España

La recolección de los datos mostrados en el Monitor de Odio es diaria. A pesar de ello, en el Monitor solo se muestra la presencia de expresiones tendentes al odio/no odio general, a partir de la integración de los mensajes recabados a nivel de los cinco medios informativos digitales tomados como caso de estudio en este proyecto. Datos que aparecen en ciclos de 7 días. Por tanto, si un usuario accede a este monitor, el porcentaje de odio/no odio recabado en los últimos 7 días en el Monitor, al momento de la consulta.

Inicialmente se concebió en Hatemedia la extracción de la totalidad de mensajes provenientes de los casos estudiados, en Facebook, Twitter y sus portales web.

Por problemas asociados a la dificultad de extraer datos directamente de Facebook, a octubre de 2023, el Monitor de Odio no muestra datos recabados diariamente de Facebook. Se ha habilitado la sección ¨Facebook (Muestra)¨, para mostrar a los usuarios la presencia de expresiones de odio en los usuarios de los medios informativos digitales tomados como casos de estudio durante enero de 2023.

Por tanto, el Monitor de Odio solo se muestran los datos generales extraídos, a partir de todos los mensajes con expresiones tendentes al odio identificados desde los usuarios en Twitter y portales institucionales, del conjunto de medios informativos digitales estudiados.

La opción por Twitter respondió a que:

La selección de Facebook se basó en que:

Más información, acceder a la memoria del proyecto aprobado por la Agencia Estatal de Investigación – Ministerio de Ciencia e Innovación. |

La detección de expresiones tendentes al odio, fue realizado también desde un proceso de extracción de características que fueron tenidas en consideración, para el entrenamiento del modelo de aprendizaje automático empleado, para la detección del porcentaje de odio detectado desde los escenarios de comunicación empleados a nivel de medios informativos digitales estudiados:

- Conteo de palabras positivas.

- Conteo de palabras negativas.

- Conteo de bigrams más comunes.

- Conteno de menciones de otros usuarios.

El objetivo final de esta extracción es determinar patrones útiles que sirviesen al entrenamiento del modelo de aprendizaje empleado para la puesta en marcha de la primera versión de este Monitor de Expresiones Tendentes al Odio.

El algoritmo que ayuda a la detección de expresiones tendente de odio, se basa en modelos de aprendizajes automáticos validados por el equipo técnico a cargo del proyecto, en colaboración con la empresa Possible Inc. A continuación se muestran los datos de rendimiento del método de clasificación tomado para la clasificación de expresiones de odio en los mensajes mostrados en el Monitor de Odio:

- Accuracy: 90%

- Precisión: 0.9001

- Recall: 0.9001

- F1-Score: 0.9001

CONOCE LOS TÉRMINOS ASOCIADOS Para facilitar la comprensión de estos resultados, se explican a continuación lo que implica cada uno de estos indicadores:

|

—

Proceso de recolección de datos en Monitor

Plataforma X (antes Twitter):

A partir de julio de 2023, a raiz de las restricciones impuestas por la Plataforma X (antes Twitter), para la recopilación de datos desde la API Académica, el Monitor de Odio, hace uso de la API Tier 2 Basic de X, para tal propósito. Una de las características de esta API es que solo nos permite recopilar 10k mensajes mensuales. Por lo que se ha establecido un plan de recolección, a partir de una muestra estratificada por número de mensajes promedios mensual, recabados en cada medio informativo digital, durante el proceso de recolección de datos tomados para el desarrollo del proyecto del que parte este Monitor, con e=+/-1% y 1-∝=97%:

| Medios | % Mensajes mensual | Semana 1 | Semana 2 | ||||||||||||

| L | M | X | J | V | S | D | L | M | X | J | V | S | D | ||

| 20 Mins | 8% | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 |

| ABC | 21% | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 |

| El Mundo | 37% | 133 | 132 | 132 | 132 | 132 | 132 | 132 | 132 | 133 | 132 | 132 | 132 | 132 | 132 |

| El País | 26% | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 |

| La Vanguardia | 7% | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 |

| Semana 3 | Semana 4 | ||||||||||||

| L | M | X | J | V | S | D | L | M | X | J | V | S | D |

| 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 | 29 |

| 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 | 79 |

| 132 | 132 | 133 | 132 | 132 | 132 | 132 | 132 | 132 | 132 | 133 | 132 | 132 | 132 |

| 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 93 | 92 | 92 | 92 | 92 |

| 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 | 25 |

* El plan de recolección tomado para el mantenimiento del Monitor puede verse afectado puntualmente, en vista de las restricciones técnicas de la API empleada para tal fin.

** N=todos los mensajes publicados por los diferentes usuarios vinculados a los medios informativos digitales tomados como caso de estudio, y comentarios publicados por sus seguidores, alrededor de estas publicaciones.

Portales Web Institucionales:

Los datos mostrados en el Monitor de Odio, corresponden con la totalidad de noticias publicadas por cada medio informativo y los comentarios asociadas a estas, al momento de hacer la recolección diaria de los datos que se muestran en el Monitor.

A TENER EN CUENTA Se realizan pruebas periódicas que ayudan a garantizar el cumplimiento de los parámetros de recolección de datos pautados en X y Web para la medición del odio en nuestro Monitor. Un proceso que se revisa periódicamente, con el fin de garantizar el número mínimo de elementos requeridos para el correcto funcionamiento esta herramienta; así como el consumo excesivo de solicitudes requeridas para tal fin. El procedimiento mensual de recolección de datos en X, deberá cumplir con los niveles de error admitidos como válidos dentro del proyecto, por parte de los investigadores que le integran, a saber: +/-7 de diferencia máxima admitida, respecto a la muestra mensual estimada para cada medio y tipo de contenido recolectado. |

Acceso a los algoritmos de clasificación de Odio/No odio, intensidad y tipo de odio:

Créditos

La versión final del Monitor de odio ha sido desarrollado por:

Elias Said-Hung, PhD – IP del proyecto Hatemedia / Universidad Internacional de La Rioja

Julio Montero-Díaz, PhD – IP del proyecto Hatemedia / Universidad Internacional de La Rioja

Almudena Ruíz-Iniesta, PhD – Universidad Internacional de La Rioja.

Xiomara Blanco, PhD – Universidad Internacional de La Rioja.

Daniel Pérez, PhD – Universidad Politécnica de Cataluña.

Óscar De Gregorio-Vicente, PhD – Universidad Internacional de La Rioja.

Juan José Cubillas, PhD – Universidad Internacional de La Rioja.

Este desarrollo contó con el apoyo técnico de la empresa Possible INC.